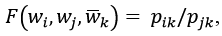

– соответственно векторы слов i, j и контекстные векторы.

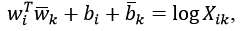

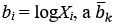

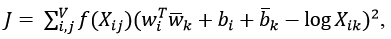

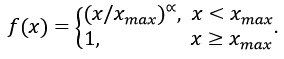

– соответственно векторы слов i, j и контекстные векторы.Вероятности извлекаются из корпуса:

При обработке текстов решается большое число задач. Вот некоторые из них [1, 2]:

- предварительная обработка (подготовка) текста;

- выделение составных частей речи, например, после_того_как, кроме_того;

- оценка сложности текста;

- разметка текста по частям речи;

- разметка текста по морфологическим признакам;

- деление слов на морфемы;

- выделение основы слова (стемминг);

- приведение слова к базовой форме (лемматизация);

- исправление ошибок;

- деление текста на предложения (sentence splitting) (возникает при генерации текстов);

- составление из независимых предложений осмысленного текста (sentence fusion);

- расстановка знаков препинания;

- распознавание именованных сущностей (имен собственных, названий географических объектов);

- разрешение лексической многозначности, снятие омонимии (указание на используемый омоним);

- построение синтаксического дерева предложения;

- определение словесных ударений;

- информационный поиск (information retrieval);

- анализ тональности текста (sentiment analysis);

- классификация текстов (документов);

- извлечение данных (знаний) из текстов (information extraction);

- выявление в предложении связанных слов и отношений между словами;

- анализ семантической эквивалентности двух фраз (paraphrase/semantic equivalence analysis);

- анализ семантического сходства текстов (semantic textual similarity – STS);

- определение эквивалентности двух вопросов (question pairs) (пример разных вопросов: "What are natural numbers?" – "What is a least natural number?");

– распознавание, является ли смысл одного текста вытекающим из другого текста (recognizing textual entailment);

- разрешение анафоры (anaphora resolution), то есть выяснение, к чему относится местоимение в тексте;

- машинный перевод (machine translation);

- ответы на вопросы (question answering);

- диалоговые модели (как вариант, чат-боты);

- автоматическое реферирование и аннотирование (text summarization);

- изложение текста другими словами (пересказ текста);

- порождение текста;

- понимание прочитанного текста (reading comprehension);

- воспроизведение текста, синтез речи по тексту.

Решение этих задач выполняется с применением моделей текста, предусматривающих представление фрагментов текста, чаще всего слов, в виде вещественных векторов. Модель текста строится на основании достаточно больших корпусов, содержащих либо случайные, например, взятые из Википедии, либо специально подобранные тексты, например, статьи по группе тем.

В работе рассматриваются известные модели текста. В случае непредобученной модели программы, выполняющие формирование корпуса на основе исходного текста и получение моделей текста. Также приводятся примеры употребления моделей в задаче классификации документов.

Источником документов в приводимых примерах является набор новостных данных Би-би-си [3] (далее обозначается как BBCD), содержащий тексты (документы) следующих категорий (после имени указано число документов данной категории): бизнес / 510, развлечения / 386, политика / 417, спорт / 511, техника / 401.

Все приводимые программы написаны на Python.

BBCD хранит документы в текстовых файлах с кодировкой UTF-8. В каждом файле один документ. Файлы разнесены по папкам с именами, указывающими на класс (категорию) документа: business, entertainment, politics, sport и tech.

Пример документа из папки sport:

Isinbayeva claims new world best

Pole vaulter Yelena Isinbayeva broke her own indoor world record by clearing 4.89 metres in Lievin on Saturday.

It was the Russian's 12th world record of her career and came just a few days after she cleared 4.88m at the Norwich Union Grand Prix in Birmingham. The Olympic champion went on to attempt 5.05m at the meeting on France but failed to clear that height. In the men's 60m, former Olympic 100m champion Maurice Greene could only finish second to Leonard Scott. It was Greene's second consecutive defeat at the hands of his fellow American, who also won in Birmingham last week. "I ran my race perfectly," said Scott, who won in 6.46secs, his best time indoors. "I am happy even if I know that Maurice is a long way from being at his peak at the start of the season."

В процессе загрузки набора формируется корпус, сохраняемый в файле b_x.txt и разбиваемый на обучающее и проверочное множества и сохраняемые соответственно в файлах b_x_t.txt и b_x_v.txt.

Каждая строка файлов хранит один документ.

При формировании корпуса текст приводится в нижний регистр и из него удаляются все символы, отличающиеся от букв английского алфавита. Такие преобразования позволяют снизить размер словаря корпуса, без ущерба решаемой задачи классификации документов.

Одновременно формируются файлы b_y.txt, b_y_t.txt и b_y_v.txt с метками документов (метка – это номер класса документа) из файлов b_y.txt, b_x_t.txt и b_x_v.txt.

Каждая строка k в файле b_y.txt (b_y_t.txt, b_y_v.txt) хранит метку документа в строке k файла b_x.txt (b_x_t.txt, b_x_v.txt).

Вдобавок создается словарь корпуса, сохраняемый в отсортированном файле b_dict.txt, и файл b_in_cls.txt с номерами классов и числом документов в них:

0 510

1 386

2 417

3 511

4 401

Описанные действия выполняет следующий код:

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # <class 'list'>

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

# Сохранение списка в текстовый файл

def add_to_txt_f(lst, fn):

print('Создан файл', fn, 'с числом строк', len(lst))

with open(fn, 'w', encoding = 'utf-8') as f:

for val in lst: f.write((val + '\n') if val.find('\n') == -1 else val)

# Пополнение словарей dict_txt и dict_in_cls

def add_in_dicts(cls, dict_in_cls, doc, dict_txt):

in_cls = dict_in_cls.get(cls)

if in_cls is None:

dict_in_cls[cls] = 1

else:

dict_in_cls[cls] += 1

lst_t = doc.split()

for w in lst_t: dict_txt[w] = 1 # Словарь корпуса

doc = ''

for w in lst_t: doc += (w + ' ')

doc = doc.rstrip()

return doc

# Обработка строки английского текста

def preprocess_en(s):

s = s.lower()

# Оставляем только английские строчные буквы, остальное заменяем пробелами

s = re.sub('[^a-z]', ' ', s)

# Заменяем одиночные буквы на пробелы

s = re.sub(r'\b[a-z]\b', ' ', s)

s = re.sub(' +', ' ', s) # Заменяем несколько пробелов одним

return s.strip() # Удаляем начальный и конечные пробелы

#

import os, time, re

from sklearn.model_selection import train_test_split

pre_ds = 'b_' # '4_', если BACD

fn_x = pre_ds + 'x.txt'

fn_y = pre_ds + 'y.txt'

fn_d = pre_ds + 'dict.txt'

fn_in_cls = pre_ds + 'in_cls.txt' # Размеры классов

fn_xt = pre_ds + 'x_t.txt'

fn_yt = pre_ds + 'y_t.txt'

fn_xv = pre_ds + 'x_v.txt'

fn_yv = pre_ds + 'y_v.txt'

num_classes = 5 # Число классов

k_split = 0.2 # Доля проверочного множества

pth = 'bbc' # Папка с документами BBCD

#pth = 'e_docs/data' # Папка с документами BACD

t0 = time.time()

print('Подготовка данных')

dict_txt = {} # Словарь корпуса

dict_in_cls = {} # Словарь классов: {номер класса, число документов в классе}

x_trn, y_trn = [], [] # Списки для документов и меток корпуса

i0 = 0

def one_data_set(pth, i0, x_trn_vl, y_trn_vl):

lst_dir = os.listdir(pth)

lst_dir = [pth + '/' + dr for dr in lst_dir if dr.find('.') == -1]

cls = -1

for dr in lst_dir:

cls += 1

print('Формирование класса', cls)

lst_fn = os.listdir(dr)

lst_fn = [dr + '/' + fn for fn in lst_fn]

for fn in lst_fn:

try:

lst_s = read_txt_f(fn, say = False)

except:

print('ERROR:', fn)

exit()

d = ''

for s in lst_s[i0:]:

if len(s.strip()) == 0: continue

s = preprocess_en(s)

d += s + ' '

d = d.split()

if len(d) < 10: continue

doc = ''

for w in d:

doc += w + ' '

doc = doc.rstrip()

s_cls = str(cls)

doc = add_in_dicts(s_cls, dict_in_cls, doc, dict_txt)

x_trn_vl.append(doc)

y_trn_vl.append(s_cls)

return x_trn_vl, y_trn_vl

x_trn, y_trn = one_data_set(pth, i0, x_trn, y_trn)

add_to_txt_f(x_trn, fn_x) # Документы корпуса и их метки

add_to_txt_f(y_trn, fn_y)

xt_all, yt_all, xv_all, yv_all = [], [], [], []

# Делим каждый класс по отдельности, поскольку набор данных несбалансирован

for cls in range(num_classes):

str_cls = str(cls)

xt = [x for x, y in zip(x_trn, y_trn) if y == str_cls]

yt = [str_cls] * len(xt)

xt, xv, yt, yv = train_test_split(xt, yt, test_size = k_split, shuffle = False)

xt_all.extend(xt)

yt_all.extend(yt)

xv_all.extend(xv)

yv_all.extend(yv)

add_to_txt_f(xt_all, fn_xt)

add_to_txt_f(yt_all, fn_yt)

add_to_txt_f(xv_all, fn_xv)

add_to_txt_f(yv_all, fn_yv)

lst_dict = list(dict_txt.keys())

lst_dict.sort()

add_to_txt_f(lst_dict, fn_d)

lst_in_cls = [itm[0] + ' ' + str(itm[1]) for itm in dict_in_cls.items()]

add_to_txt_f(lst_in_cls, fn_in_cls)

print('Длительность подготовки данных:', round(time.time() - t0, 2))

Заметим, что дополнительно на этом этапе подготовки данных нередко практикуются лемматизация и удаление стоп-слов.

В качестве стоп-слов указываются междометия, частицы, союзы, вводные слова, удаление которых снижает размер корпуса и его словаря, а также нередко влечет и повышение качества ожидаемого результата.

Лемматизация – это приведение словоформы к лемме, или нормальной форме.

В русском языке леммами считаются следующие морфологические формы [4]:

- имя существительное в именительном падеже и единственном числе;

- имя прилагательное в именительном падеже, единственном числе, мужского рода;

- глагол, причастие, деепричастие – глагол несовершенного вида в инфинитиве.

Примеры:

отпотели скованные ночным заморозком лужи талой воды – отпотеть скованный ночное заморозок лужа талый вода;

жалобно скрипели оконные ставни - жалобно скрипеть оконный ставень.

При работе с русскими текстами переход к леммам осуществляет следующая функция:

# Заменяет слова леммами

def to_normal_form(morph, s):

s2 = s.split() # Список слов предложения s

s = ''

for w in s2:

w = morph.parse(w)[0].normal_form

s += (' ' + w)

return s.lstrip()

import pymorphy2

morph = pymorphy2.MorphAnalyzer()

sen = to_normal_form(morph, 'жалобно скрипели оконные ставни')

Аналогичным образом находятся леммы и в английских предложениях, но уже с применением иного лемматизатора:

from nltk.stem import WordNetLemmatizer

import nltk

nltk.download('wordnet') # Загружаем единожды

lemmatizer = WordNetLemmatizer()

sen = 'rocks corpora'

for w in sen.split():

print(w, '-', lemmatizer.lemmatize(w))

Результат:

rocks - rock

corpora - corpus

Вычисляются следующие характеристики BBCD:

- число предложений;

- число слов;

- число слогов;

- число многосложных слов (слов с числом слогов более 3);

- число букв;

- число символов, отличных от букв.

import os, re

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # <class 'list'>

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

pth = 'bbc' # Папка с документами BBCD

vowels = 'aeiouy' # Гласные

n_sens = n_words = n_syls = n_с_syls = n_lets = n_all_symbs = 0

lst_dir = os.listdir(pth)

lst_dir = [pth + '/' + dr for dr in lst_dir if dr.find('.') == -1]

for dr in lst_dir:

lst_fn = os.listdir(dr)

lst_fn = [dr + '/' + fn for fn in lst_fn]

for fn in lst_fn:

lst_d = read_txt_f(fn, say = False)

for d in lst_d:

d = d.strip()

if len(d) == 0: continue

d = d.lower()

# Всего символов в документе за вычетом пробелов

n_d_symbs = len(d) - d.count(' ')

n_all_symbs += n_d_symbs # Всего символов в наборе данных

for sen in re.split('[\.?!…]{1,} ', d): # Делим документ на предложения

n_sens += 1 # Число предложений

# Оставляем только строчные буквы; остальное заменяем пробелами

sen = re.sub('[^a-z]', ' ', sen)

sen = re.sub(' +', ' ', sen) # Заменяем несколько пробелов одним

sen = sen.rstrip()

# Всего букв в предложении за вычетом пробелов

n_sen_lets = len(sen) - sen.count(' ')

# Всего букв в наборе данных

n_lets += n_sen_lets

for w in sen.split():

n_words += 1 # Число слов в наборе данных

n_w_syls = 0 # Число слогов в слове

for c in w:

if c in vowels:

n_w_syls += 1

n_syls += n_w_syls # Число слогов в наборе данных

if n_w_syls > 3:

n_с_syls += 1 # Число многосложных слов в наборе данных

print('Всего предложений:', n_sens)

print('Всего слов:', n_words)

print('Всего слогов:', n_syls)

print('Всего многосложных слов:', n_с_syls)

print('Всего букв:', n_lets)

print('Всего не букв:', n_all_symbs - n_lets)

Статистические характеристики BBCD:

Всего предложений: 42'091;

Всего слов: 859'442;

Всего слогов: 1'579'770;

Всего многосложных слов: 71'560;

Всего букв: 3'989'442;

Всего не букв: 185'087.

К ним можно добавить еще три:

Число классов: 5;

Число документов: 2'225;

Размер словаря корпуса: 27'880.

Библиотека scikit-learn предоставляет доступ к перечисленным в табл. 3.1 классификаторам.

В ней же указаны результаты их употребления для классификации документов русскоязычного набора данных [48] (табл. 3.2).

Таблица 3.1. Классификаторы scikit-learn

| № | Обозначение | Наименование | val_acc, % |

|---|---|---|---|

| 1 | AdaBoost | Адаптивный бустинг (adaptive boosting) | 39,18 |

| 2 | Decision tree | Дерево решений | 52,34 |

| 3 | Gaussian Naive Bayes | Гауссовский наивный байесовский классификатор | 58,33 |

| 4 | Gaussian process | Гауссовская классификация (очень долго) (основана на аппроксимации Лапласа) | 63,16 |

| 5 | K-Nearest Neighbors | Метод K-ближайших соседей | 66,52 |

| 6 | Linear Discriminant Analysis | Линейный дискриминантный анализ | 21,93 |

| 7 | Logistic Regression | Логистическая регрессия | 69,88 |

| 8 | Multi-layer Perceptron | Многослойный перцептрон | 68,13 |

| 9 | Multinomial Naive Bayes | Мультиноминальный наивный байесовский классификатор | 68,13 |

| 10 | PassiveAggressive | Пассивно-агрессивный классификатор | 68,86 |

| 11 | Perceptron | Перцептрон | 65,79 |

| 12 | Quadratic Discriminant Analysis | Квадратичный дискриминантный анализ | 15,7 |

| 13 | Random Forest Classifier | Случайный лес (используются деревья решений) | 69,74 |

| 14 | SGD Classifier | Линейный классификатор с SGD-обучением (stochastic gradient descent - стохастический градиентный спуск) | 68,27 |

| 15 | Support Vector Classification | Метод опорных векторов | 65,94 |

| 16 | Support Vector Machines | Метод опорных векторов (kernel = 'linear') | 17,54 |

Таблица 3.2. Классы документов набора данных

| № | Класс | Число документов |

|---|---|---|

| 1 | Автомобили | 249 |

| 2 | Здоровье | 155 |

| 3 | Культура | 357 |

| 4 | Наука | 227 |

| 5 | Недвижимость | 98 |

| 6 | Политика | 600 |

| 7 | Происшествия | 436 |

| 8 | Реклама | 94 |

| 9 | Семья | 101 |

| 10 | Спорт | 371 |

| 11 | Страна | 146 |

| 12 | Техника | 285 |

| 13 | Экономика | 272 |

Классификаторы применены с заданными по умолчанию параметрами.

Докумены подаются на входы классификаторов в виде TF-IDF-векторов (см. разд. 5.4).

Для экспериментов с рассматриваемыми в работе текстовыми моделями взят класссификатор SGD.

Данные, подготовленные с использованием текстовых моделей, передаются НС с архитектурой многослойного перцептрона с одним скрытым слоем.

Создание НС обеспечивает следующий код:

#num_classes - число классов документов

#n_attrs_in_doc - размер вектора, представляющего документ

def nn_model(num_classes, n_attrs_in_doc):

from keras.models import Model

from keras.layers import Input, Dropout, Dense

inp_shape = (n_attrs_in_doc, )

print('Формируем модель НС')

inp = Input(shape = inp_shape, dtype = 'float32')

x = Dropout(0.3)(inp)

x = Dense(32, activation = 'relu')(x)

output = Dense(num_classes, activation = 'softmax')(x)

model = Model(inp, output)

model.summary()

model.compile(optimizer = 'adam', loss = 'categorical_crossentropy', metrics = ['accuracy'])

return model

НС, обученная классифицировать документы набора данных [48] (табл. 3.2), показывает при тестировании точность классификации, равную 70,61%

(модель документа - TF-IDF).

Работа с текстовыми моделями, применяемыми для представления документов, ведется классификаторами SGD и НС (см. разд. 3.2).

Создание, обучение и тестирование SGD и НС обеспечивает следующая процедура, принимающая векторы и метки документов обучающего и проверочного множеств:

def classify(x_trn, y_trn, x_vl, y_vl):

from sklearn.linear_model import SGDClassifier

doc_clf = SGDClassifier(loss = 'hinge', max_iter = 1000, tol = 1e-3)

doc_clf.fit(x_trn, y_trn) # Обучение классификатора

print('Оценка точности классификации')

score = doc_clf.score(x_vl, y_vl)

print('Точность на проверочном множестве:', round(score, 4))

score = doc_clf.score(x_trn, y_trn)

print('Точность на обучающем множестве:', round(score, 4))

#

epochs = 90 # Число эпох обучения НС

num_classes = 5 # Число классов

def nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc):

import keras.utils as ut

model = nn_model(num_classes, n_attrs_in_doc) # Создаем модель НС

print('Преобразуем списки в массивы')

x_trn = np.array(x_trn, dtype = 'float32')

x_vl = np.array(x_vl, dtype = 'float32')

# Переводим метки в one-hot представление

y_trn = ut.to_categorical(y_trn, num_classes)

y_vl = ut.to_categorical(y_vl, num_classes)

# Обучаем НС

model.fit(x_trn, y_trn, batch_size = 64, epochs = epochs, verbose = 2,

validation_data = (x_vl, y_vl))

# Оценка модели НС на оценочных данных

score = model.evaluate(x_vl, y_vl, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

# После преобразования: x_trn, x_vl: class 'numpy.ndarray'

n_attrs_in_doc = len(x_vl[0])

print('Число признаков в документе:', n_attrs_in_doc)

nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc)

Классификатор вычисляет две следующие оценки:

val_acc – точность классификации на проверочном множестве;

acc – точность классификации на обучающем множестве.

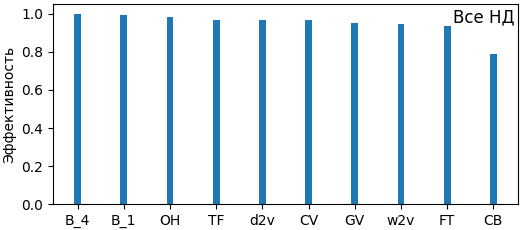

С каждой моделью текста классификаторы запускаются трижды, после чего находятся средние значения val_acc и acc.

Для оценки модели текста берется наименьшее из двух полученных средних значений.

Рассматриваются следующие модели текстов: вектор кодов слова и его частей слова (КЧС), one-hot, мешок слов (два варианта), LDA, LSA, частотно-классовая модель (ЧКМ), случайный вектор (СВ), word2vec, doc2vec, fasttext, GloVe и модели на архитектуре трансформеров, такие, как GPT-2, BERT и др.

Все модели представляют в виде вектора слово, или документ, или и слово, и документ. Длина вектора – это либо параметр модели, либо равна числу слов в словаре модели, либо равна числу классов (тем) в корпусе, по которому создается модель.

Рассматриваемые модели, кроме КЧС и СВ, отражают либо частотные характеристики слов корпуса, например LDA, либо связи между словами, например word2vec.

Модели текстов после формирования используются в задаче классификации документов BBCD.

В качестве классификаторов поочередно берутся SGDClassifier библиотеки scikit-learn и нейронная сеть (НС) многослойный перцептрон с одним скрытым слоем.

Замечания.

1. В общем случае модели текста оперируют токенами– единицами текста: словами, знаками препинания, числами и пр. В корпусе, созданном на основе BBCD, после предварительной обработки остаются только слова. Поэтому понятие токен в излагаемом материале употребляется только при описании моделей, например BERT, обладающих собственными токенизаторами – программами, преобразующими франмент текста в последовательность токенов.

2. Во всех случаях вектор документа, когда он не предоставляется моделью текста, формируется в результате усреднения векторов слов документа.

В КЧС слово word представляется в виде списка из n (n ≥ 2) признаков:

word, word[-n:], ..., word[-2:],

где word[-x:] – последние x букв слова.

Если n = 1, то берется только слово.

Части слова дополняются символом '_', что позволяет различить часть слова от слова с таким же написанием. Например, лед_ в слове след не совпадет со словом лед.

Пример.

word = 'корова'; n = 4. Строковая модель слова: 'корова', 'рова_', 'ова_', 'ва_'.

word = 'след'; n = 4. Строковая модель слова: 'след', '', 'лед_', 'ед_'.

Далее на основе этого представления создается модель слова, в которой признаки (слово и его части) заменяются своими числовыми кодами.

Для замены признаков своими кодами составляется единый словарь признаков – слов и их двух, трех, ..., n последних букв.

В качестве числового кода признака берется его номер в этом словаре.

Далее числовые признаки нормируются: код признака делится на размер словаря признаков.

Пример.

Слово word = 'корова'; n = 3.

Строковая модель слова: ('корова', 'ова_', 'ва_').

Числовая модель слова: [54758, 81020, 73216].

Нормализованная числовая модель слова: [0.5306, 0.78508, 0.70945].

Модель документа получается в результате замены каждого его слова нормализованной числовой моделью слова.

Пример.

# Корпус из двух документов

corp = [

'Корову свою не продам никому –',

'Такая скотина нужна самому!']

# После обработки

corp = [

('корову', 'свою', 'не', 'продам', 'никому'),

('такая', 'скотина', 'нужна', 'самому')]

n_atrs = 2 # Число признаков

suff = '_' # Символ, добавляемые в конец части слова

dict_a = {} # Словарь признаков

for doc in corp:

for w in doc:

dict_a[w] = 1

dict_a[w[-2:] + suff] = 1

N = len(dict_a) # Размер словаря признаков

# Нумерация и нормализация числовых значений признаков

v = 0

for a in dict_a.keys():

v += 1

dict_a[a] = v / N

lst_c_doc = [] # Числовая модель первого документа

for w in corp[0]:

lst_c_doc.extend([dict_a[w], dict_a[w[-2:] + suff]])

print(lst_c_doc)

# [0.0625, 0.125, 0.1875, 0.25, 0.3125, 0.375, 0.4375, 0.5, 0.5625, 0.625]

Основной недостаток модели в том, что она не отражает ни частотных характеристик корпуса, ни отношений между его словами.

В задаче классификации документов с применением КЧС формируется список lst_corp_codes, содержащие числовые представления документов.

Номера их классов загружаются в список и lst_cls.

Формирование списков выполняется в результате выполнения следующих действий:

1. Загрузить в список lst_dict словарь корпуса текста.

2. Создать основании списка lst_dict словарь dict_a, с ключом "слово " или "часть слова" и значением "номер (части) слова в словаре".

3. Загрузить документы корпуса и их метки соответственно в списки lst_corp и lst_cls.

4. lst_corp_codes = [] # Модель корпуса

5. Для каждого документа doc из lst_corp:

doc_codes = [0]*n_attrs # Модель документа – массив из n_attrs нулей

nw = 0 # Число слов в документе

Для каждого слова w из doc:

nw = nw + 1

Создать массив w_codes из n_attrs числовых признаков слова w

(значения числовых признаков берутся из словаря dict_a).

doc_codes = doc_codes + w_codes.

doc_codes = doc_codes / nw

Добавить doc_codes в lst_corp_codes.

Таким образом, каждый документ заменяется вектором из n_attrs числами, где n_attrs – число признаков в модели слова.

Названные выше действия реализует следующий код:

import numpy as np

print('Модель слова в виде кодов слова и его частей')

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

# Формирование из списка слов словаря с элементами {слово:код слова}

def make_dict_from_list(lst, k0):

dict_x = {}

k = k0

for x in lst:

k += 1

if dict_x.get(x) is None:

dict_x.update({x : k})

return dict_x

# Пополняет словарь признаков по списку строковых признаков

def update_dict_a(lst_a, dict_a, suff = '_'):

lst_a = list(set(lst_a))

for a in lst_a:

a += suff

if dict_a.get(a) is None:

dict_a.update({a : 1})

return dict_a

# Формирует список числовых признаков по списку строковых признаков

def make_lst_c(lst_a, dict_a, suff = '_'):

lst_c = []

for a in lst_a:

a += suff

c = dict_a.get(a)

c = [0] if c is None else [c]

lst_c.extend(c)

return lst_c

def add_ends(dict_a, n_attrs):

lst_a = []

for w in dict_a.keys():

for n in range(2, n_attrs + 1):

lst_a.append(w[-n:])

return update_dict_a(lst_a, dict_a)

# Формируем список числовых признаков слова w

def find_ends(w, dict_a, n_attrs):

lst_a = []

for n in range(2, n_attrs + 1):

lst_a.append(w[-n:])

return make_lst_c(lst_a, dict_a)

def read_corp():

path = ''

fn_xt, fn_yt, fn_d = 'b_x_t.txt', 'b_y_t.txt', 'b_dict.txt'

fn_xv, fn_yv = 'b_x_v.txt', 'b_y_v.txt'

x_trn = read_txt_f(path + fn_xt)

y_trn = read_txt_f(path + fn_yt, to_int = True)

x_vl = read_txt_f(path + fn_xv)

y_vl = read_txt_f(path + fn_yv, to_int = True)

# Список из слов словаря корпуса

lst_dict = read_txt_f(fn_d)

return x_trn, y_trn, x_vl, y_vl, lst_dict

def train_test_data(x_trn, x_vl, lst_dict):

n_attrs = 4 # Число признаков в модели слова

print('Число признаков в слове:', n_attrs)

# Формируем начальный словарь атрибутов

dict_a = make_dict_from_list(lst_dict, 0)

# Добавляем в словарь части слов и получаем полный словарь атрибутов

dict_a = add_ends(dict_a, n_attrs)

lst_dict_a = list(dict_a.keys())

lst_dict_a.sort()

N = len(lst_dict_a) # Размер словаря атрибутов

dict_a = make_dict_from_list(lst_dict_a, 0)

# Приводим значения признаков к диапазону (0, 1] (нормализация)

for a in dict_a.keys(): dict_a[a] /= N

def mk_x_trn_vl_codes(x_trn_vl, n_attrs, dict_a):

x_trn_vl_codes = []

# Замена слов на числовые признаки слова и его частей

nc_max = 0

for doc in x_trn_vl:

doc = doc.split()

nw = 0

lst_codes = np.zeros(n_attrs)

for w in doc:

cw = dict_a.get(w)

if cw is not None:

lst_c = [cw]

lst_c.extend(find_ends(w, dict_a, n_attrs))

nw += 1

lst_codes += np.array(lst_c)

lst_codes /= nw

x_trn_vl_codes.append(lst_codes)

return x_trn_vl_codes

x_trn = mk_x_trn_vl_codes(x_trn, n_attrs, dict_a)

x_vl = mk_x_trn_vl_codes(x_vl, n_attrs, dict_a)

return x_trn, x_vl

def classify(x_trn, y_trn, x_vl, y_vl):

from sklearn.linear_model import SGDClassifier

doc_clf = SGDClassifier(loss = 'hinge', max_iter = 1000, tol = 1e-3)

doc_clf.fit(x_trn, y_trn) # Обучение классификатора

print('Оценка точности классификации')

score = doc_clf.score(x_vl, y_vl) # class 'numpy.float64'

print('Точность на проверочном множестве:', round(score, 4))

score = doc_clf.score(x_trn, y_trn) # class 'numpy.float64'

print('Точность на обучающем множестве:', round(score, 4))

#

epochs = 90 # Число эпох обучения НС

num_classes = 5 # Число классов

def nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc):

from keras.models import Model

from keras.layers import Input, Dropout, Dense

import keras.utils as ut

print('Преобразуем списки в массивы')

x_trn = np.array(x_trn, dtype = 'float32')

x_vl = np.array(x_vl, dtype = 'float32')

# Переводим метки в one-hot представление

y_trn = ut.to_categorical(y_trn, num_classes)

y_vl = ut.to_categorical(y_vl, num_classes)

inp_shape = (n_attrs_in_doc, )

print('Формируем модель НС')

inp = Input(shape = inp_shape, dtype = 'float32')

x = Dropout(0.3)(inp)

x = Dense(32, activation = 'relu')(x)

output = Dense(num_classes, activation = 'softmax')(x)

model = Model(inp, output)

model.summary()

model.compile(optimizer = 'adam', loss = 'categorical_crossentropy', metrics = ['accuracy'])

# Обучаем НС

model.fit(x_trn, y_trn, batch_size = 64, epochs = epochs, verbose = 2,

validation_data = (x_vl, y_vl))

# Оценка модели НС на оценочных данных

score = model.evaluate(x_vl, y_vl, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

# После преобразования: x_trn, x_vl: class 'numpy.ndarray'

n_attrs_in_doc = len(x_vl[0])

print('Число признаков в документе:', n_attrs_in_doc)

nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc)

#

x_trn, y_trn, x_vl, y_vl, lst_dict = read_corp()

x_trn, x_vl = train_test_data(x_trn, x_vl, lst_dict)

#

# Полученные векторы документов передаются классификаторам – SGD и НС

# Классификация выполняется трижды

# Результаты (точность классификации) усредняются

for k in range(3):

print('Номер попытки:', k + 1)

classify(x_trn, y_trn, x_vl, y_vl)

Результаты:

| Номер попытки | SGD | НС | ||

|---|---|---|---|---|

| val_acc | acc | val_acc | acc | |

| 1 | 24.78 | 24.59 | 22.99 | 24.65 |

| 2 | 30.36 | 30.67 | 31.92 | 23.47 |

| 3 | 32.14 | 32.70 | 31.03 | 23.58 |

В этой модели слово заменяется вектором размера N, где N – число слов в словаре корпуса.

Если номер слова в словаре равен k, то в векторе, замещающем слово, компонент k - 1 равен 1, а остальные компоненты вектора равны нулю.

Чтобы получить one-hot представление документа, нужно заменить каждое его слово на соответствующий one-hot вектор.

Пример.

from sklearn.preprocessing import OneHotEncoder

import numpy as np

# Корпус из 4-х документов

corp = [

'Заяц в лес бежал по лугу,',

'Я из лесу шел домой, –',

'Бедный заяц с перепугу',

'Так и сел передо мной!']

# После обработки

corp = [

('заяц', 'в', 'лес', 'бежал', 'по', 'лугу'),

('я', 'из', 'лесу', 'шел', 'домой'),

('бедный', 'заяц', 'с', 'перепугу'),

('так', 'и', 'сел', 'передо', 'мной')]

encoder = OneHotEncoder(sparse = False)

# Список слов корпуса

corp_words = []

for doc in corp:

corp_words.extend([w for w in doc])

# Массив слов корпуса для encoder.fit

arr_words = np.array(corp_words).reshape(len(corp_words), 1)

one_hot = encoder.fit(arr_words)

# Имена признаков (словарь)

feature_names = one_hot.get_feature_names()

# arr_one_hot_words – массив формы (len(corp_words), len(feature_names))

# Массив one-hot представлений слов документа

arr_one_hot_words = one_hot.transform(arr_words)

# Вывод one-hot представлений слов первого документа

print(arr_one_hot_words[:len(corp[0]), :])

[[0. 0. 0. 0. 1. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.] # 'заяц'

[0. 0. 1. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.] # 'в'

[0. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.] # 'лес'

[0. 1. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0.] # 'бежал'

[0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 0. 0.] # 'по'

[0. 0. 0. 0. 0. 0. 0. 0. 0. 1. 0. 0. 0. 0. 0. 0. 0. 0. 0.]] # 'лугу'

Можно сразу получить векторы всех слов:

arr_one_hot_words = encoder.fit_transform(arr_words) # class 'numpy.ndarray'

One-hot модель первого документа:

nw = 0

one_hot_doc = np.zeros(len(feature_names))

for one_hot_word in arr_one_hot_words[:len(corp[0]), :]:

nw += 1

one_hot_doc += one_hot_word

one_hot_doc /= nw

[0. 0.167 0.167 0. 0.16 0. 0. 0.167 0. 0.167 0. 0. 0. 0.167 0. 0. 0. 0. 0.]

Очевидные недостатки модели – это ее большой размер, игнорирование связей между словами и неразличение омонимов.

Подготовка данных для обучения и тестирования классификаторов выполняется по файлам, содержащим обработанные документы и список слов словаря корпуса.

Данные формирует и передает классификаторам следующий код:

import numpy as np

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

def read_corp():

path = ''

fn_xt, fn_yt, fn_d = 'b_x_t.txt', 'b_y_t.txt', 'b_dict.txt'

fn_xv, fn_yv = 'b_x_v.txt', 'b_y_v.txt'

x_trn = read_txt_f(path + fn_xt)

y_trn = read_txt_f(path + fn_yt, to_int = True)

x_vl = read_txt_f(path + fn_xv)

y_vl = read_txt_f(path + fn_yv, to_int = True)

# Список из слов словаря корпуса

lst_dict = read_txt_f(fn_d)

return x_trn, y_trn, x_vl, y_vl, lst_dict

def train_test_one_hot(x_trn, x_vl, lst_dict):

from sklearn.preprocessing import OneHotEncoder

print('Модель one-hot')

len_dict = len(lst_dict)

encoder = OneHotEncoder(sparse = False)

arr_words = np.array(lst_dict).reshape(len_dict, 1)

arr_one_hot_words = encoder.fit_transform(arr_words)

# Словарь корпуса: {слово:one-hot представление слова}

dict_corp = {}

for w, c in zip(lst_dict, arr_one_hot_words):

dict_corp[w] = c

arr_words = arr_one_hot_words = '' # Для сокращения издержек памяти

def make_trn_vl_1(x_trn_vl):

x_trn_vl_one_hot = []

# Замена слов на one-hot представления

nc_max = 0

for doc in x_trn_vl:

doc = doc.split()

nw = nv = 0

cw_sum = np.zeros(len_dict)

for w in doc:

c = dict_corp.get(w)

if c is not None:

nw += 1

cw_sum += c

x_trn_vl_one_hot.append(cw_sum / nw)

return x_trn_vl_one_hot

x_trn = make_trn_vl_1(x_trn)

x_vl = make_trn_vl_1(x_vl)

return x_trn, x_vl

def classify(x_trn, y_trn, x_vl, y_vl):

from sklearn.linear_model import SGDClassifier

doc_clf = SGDClassifier(loss = 'hinge', max_iter = 1000, tol = 1e-3)

doc_clf.fit(x_trn, y_trn) # Обучение классификатора

print('Оценка точности классификации')

score = doc_clf.score(x_vl, y_vl)

print('Точность на проверочном множестве:', round(score, 4))

score = doc_clf.score(x_trn, y_trn)

print('Точность на обучающем множестве:', round(score, 4))

#

epochs = 90 # Число эпох обучения НС

num_classes = 5 # Число классов

def nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc):

from keras.models import Model

from keras.layers import Input, Dropout, Dense

import keras.utils as ut

print('Преобразуем списки в массивы')

x_trn = np.array(x_trn, dtype = 'float32')

x_vl = np.array(x_vl, dtype = 'float32')

# Переводим метки в one-hot представление

y_trn = ut.to_categorical(y_trn, num_classes)

y_vl = ut.to_categorical(y_vl, num_classes)

inp_shape = (n_attrs_in_doc, )

print('Формируем модель НС')

inp = Input(shape = inp_shape, dtype = 'float32')

x = Dropout(0.3)(inp)

x = Dense(32, activation = 'relu')(x)

output = Dense(num_classes, activation = 'softmax')(x)

model = Model(inp, output)

model.summary()

model.compile(optimizer = 'adam', loss = 'categorical_crossentropy', metrics = ['accuracy'])

# Обучаем НС

model.fit(x_trn, y_trn, batch_size = 64, epochs = epochs, verbose = 2,

validation_data = (x_vl, y_vl))

# Оценка модели НС на оценочных данных

score = model.evaluate(x_vl, y_vl, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

# После преобразования: x_trn, x_vl: class 'numpy.ndarray'

n_attrs_in_doc = len(x_vl[0])

print('Число признаков в документе:', n_attrs_in_doc)

nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc)

#

x_trn, y_trn, x_vl, y_vl, lst_dict = read_corp()

x_trn, x_vl = train_test_one_hot(x_trn, x_vl, lst_dict)

#

# Полученные векторы документов передаются классификаторам – SGD и НС

# Классификация выполняется трижды

# Результаты (точность классификации) усредняются

for k in range(3):

print('Номер попытки:', k + 1)

classify(x_trn, y_trn, x_vl, y_vl)

Результаты:

| Номер попытки | SGD | НС | ||

|---|---|---|---|---|

| val_acc | acc | val_acc | acc | |

| 1 | 86.61 | 86.10 | 99.33 | 99.94 |

| 2 | 91.74 | 87.90 | 99.11 | 99.94 |

| 3 | 87.95 | 88.91 | 99.11 | 100.0 |

Документ d представляется вектором x, который формируется по словарю dict_w с элементами {word:i}, где i – номер word в dict_w), следующим образом:

1. Взять вектор x из N нулей, где N – размер словаря dict_w.

2. Для Каждого word Из d:

i = dict_w[word]

x[i] = x[i] + 1

Таким образом, вектор, представляющий документ, содержит в позиции с индексом, равным номеру слова в словаре, число присутствий слова в документе.

Другое название модели – мешок слов [5].

Вектор, представляющий документ, можно сделать бинарным:

Если x[i] == 0: x[i] = x[i] + 1

Принцип построения небинарного вектора иллюстрирует следующий пример:

from sklearn.feature_extraction.text import CountVectorizer

corp = [

'Заяц в лес бежал по лугу,',

'Я из лесу шел домой, –',

'Бедный заяц с перепугу (заяц)',

'Так и сел передо мной!']

vectorizer = CountVectorizer(token_pattern = '\w+') # binary = True

x = vectorizer.fit_transform(corp) # x – class 'scipy.sparse.csr.csr_matrix'

feature_names = vectorizer.get_feature_names() # class 'list'

arr_x = x.toarray() # arr_x – class 'numpy.ndarray'

print(feature_names)

print(arr_x)

Признаки (feature_names):

['бедный', 'бежал', 'в', 'домой', 'заяц', 'и', 'из', 'лес', 'лесу', 'лугу', 'мной', 'передо', 'перепугу', 'по', 'с', 'сел', 'так', 'шел', 'я']

Модель корпуса (arr_x):

[[0 1 1 0 1 0 0 1 0 1 0 0 0 1 0 0 0 0 0] # 'заяц в лес бежал по лугу'

[0 0 0 1 0 0 1 0 1 0 0 0 0 0 0 0 0 1 1] # 'я из лесу шел домой'

[1 0 0 0 2 0 0 0 0 0 0 0 1 0 1 0 0 0 0] # 'бедный заяц с перепугу заяц'

[0 0 0 0 0 1 0 0 0 0 1 1 0 0 0 1 1 0 0]] # 'так и сел передо мной'

Замечание. CountVectorizer без token_pattern = '\w+' исключит из списка признаков токены единичной длиной – в, и, с, я.

Если задать

vectorizer = CountVectorizer(token_pattern = '\w+', binary = True),

то векторы, представляющие документы, будут бинарными, то есть содержать только нули и единицы.

Положительная черта такого кодирования документов – это инвариантность к его длине: любой документ отображается вектором, длина которого равна числу слов в словаре. Недостаток заключается в игнорировании связей между словами корпуса.

Больший эффект, например, при обучении классификатора можно получить, если выполнить нормализацию данных, возвращаемых методом CountVectorizer, применив TfidfTransformer:

from sklearn.feature_extraction.text import CountVectorizer, TfidfTransformer

from sklearn.pipeline import Pipeline

corp = [

'Заяц в лес бежал по лугу,',

'Я из лесу шел домой, —',

'Бедный заяц с перепугу (заяц)',

'Так и сел передо мной!']

t_vec = Pipeline([('count', CountVectorizer()), ('tfid', TfidfTransformer())]).fit(corp)

arr = t_vec.transform(corp).toarray()

print(arr)

[[0. 0.421 0.421 0. 0.332 0. 0. 0.421 0. 0.421 0. 0. 0. 0.421 0. 0. 0. 0. 0.]

[0. 0. 0. 0.447 0. 0. 0.447 0. 0.447 0. 0. 0. 0. 0. 0. 0. 0. 0.447 0.447]

[0.426 0. 0. 0. 0.673 0. 0. 0. 0. 0. 0. 0. 0.426 0. 0.426 0. 0. 0. 0.]

[0. 0. 0. 0. 0. 0.447 0. 0. 0. 0. 0.447 0.447 0. 0. 0. 0.447 0.447 0. 0.]]

TfidfTransformer использует метод кодирования TF-IDF – Term Frequency-Inverse Document Frequency (частота слова в документе-обратная частота документов, содержащих слово), в котором значение признака – это нормированная величина показателя tf_idf, вычисляемого по следующей формуле [6]:

tf_idf = tf(wt, d) * idf(wt),где

tf(wt, d) – число появлений слова wt в документе d;

idf(wt)= log(n / df(wt)) + 1, если smooth_idf = False;

idf(wt)= log((1 + n) / (1 + df(wt))) + 1, если smooth_idf = True

(smooth_idf – параметр метода TfidfTransformer);

n – число документов в корпусе;

df(wt) – число документов, в которых встречается слово wt.

Такой способ кодирования позволяет повысить значимость редко встречаемых в документе слов (значимость слова тем выше, чем больше значение tf_idf).

Приведенный в предыдущем примере конвейер Pipeline можно записать с одним объединяющим конвертором:

from sklearn.feature_extraction.text import TfidfVectorizer

# TfidfVectorizer = CountVectorizer + TfidfTransformer

t_vec = TfidfVectorizer(analyzer = 'word', max_features = None)

t_vec.fit(corp)

print(t_vec.transform(corp).toarray())

Данные, получаемые на выходе CountVectorizer и TfidfVectorizer, имеют тип scipy.sparse.csr.csr_matrix, то есть хранятся в разреженном csr-представлении.

Пример.

import numpy as np

from scipy.sparse import csr_matrix

arr = np.array([[1, 0, 0, 1, 0, 0], [0, 0, 2, 0, 0, 1], [0, 0, 0, 2, 0, 0]])

#[[1 0 0 1 0 0]

# [0 0 2 0 0 1]

# [0 0 0 2 0 0]]

# Показатель разреженности массива

sparsity = 1.0 - np.count_nonzero(arr) / arr.size

print(round(sparsity, 2)) # 0.72

#

# Преобразование массива в csr-матрицу

csr_mat = csr_matrix(arr)

# (0, 0) 1

# (0, 3) 1

# (1, 2) 2

# (1, 5) 1

# (2, 3) 2

# Преобразование csr-матрицы в плотный массив:

arr = csr_mat.todense()

# или:

arr = csr_mat.toarray()

В задаче классификации документов при использовании рассматриваемой модели на вход SGDClassifier подаются матрицы в разреженном csr-представлении, подготовленные CountVectorizer и TfidfVectorizer:

import numpy as np

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

def read_corp():

path = ''

fn_xt, fn_yt, fn_d = 'b_x_t.txt', 'b_y_t.txt', 'b_dict.txt'

fn_xv, fn_yv = 'b_x_v.txt', 'b_y_v.txt'

x_trn = read_txt_f(path + fn_xt)

y_trn = read_txt_f(path + fn_yt, to_int = True)

x_vl = read_txt_f(path + fn_xv)

y_vl = read_txt_f(path + fn_yv, to_int = True)

# Список из слов словаря корпуса

lst_dict = read_txt_f(fn_d)

return x_trn, y_trn, x_vl, y_vl, lst_dict

def classify(x_trn, y_trn, x_vl, y_vl):

from sklearn.linear_model import SGDClassifier

doc_clf = SGDClassifier(loss = 'hinge', max_iter = 1000, tol = 1e-3)

doc_clf.fit(x_trn, y_trn) # Обучение классификатора

print('Оценка точности классификации')

score = doc_clf.score(x_vl, y_vl)

print('Точность на проверочном множестве:', round(score, 4))

score = doc_clf.score(x_trn, y_trn)

print('Точность на обучающем множестве:', round(score, 4))

#

epochs = 90 # Число эпох обучения НС

num_classes = 5 # Число классов

def nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc):

from keras.models import Model

from keras.layers import Input, Dropout, Dense

import keras.utils as ut

# Переводим метки в one-hot представление

y_trn = ut.to_categorical(y_trn, num_classes)

y_vl = ut.to_categorical(y_vl, num_classes)

inp_shape = (n_attrs_in_doc, )

print('Формируем модель НС')

inp = Input(shape = inp_shape, dtype = 'float32')

x = Dropout(0.3)(inp)

x = Dense(32, activation = 'relu')(x)

output = Dense(num_classes, activation = 'softmax')(x)

model = Model(inp, output)

model.summary()

model.compile(optimizer = 'adam', loss = 'categorical_crossentropy', metrics = ['accuracy'])

# Обучаем НС

model.fit(x_trn, y_trn, batch_size = 64, epochs = epochs, verbose = 2,

validation_data = (x_vl, y_vl))

# Оценка модели НС на оценочных данных

score = model.evaluate(x_vl, y_vl, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

# После преобразования: x_trn, x_vl: class 'numpy.ndarray'

n_attrs_in_doc = len(x_vl[0])

print('Число признаков в документе:', n_attrs_in_doc)

nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc)

for clf in ['CV', 'TF']:

print('Модель:', clf)

x_trn, y_trn, x_vl, y_vl, lst_dict = read_corp()

if clf == 'CV':

from sklearn.feature_extraction.text import CountVectorizer

vec = CountVectorizer(token_pattern = '\w+', binary = False)

elif clf == 'TF':

from sklearn.feature_extraction.text import TfidfVectorizer

vec = TfidfVectorizer(analyzer = 'word', binary = False)

len_trn = len(x_trn)

x_trn.extend(x_vl) # Объединяем x_trn и x_vl и получаем полный корпус

x_trn = vec.fit_transform(x_trn)

x_vl = x_trn[len_trn:]

x_trn = x_trn[:len_trn]

# Преобразуем разреженные матрицы в массивы

x_trn = np.float32(x_trn.toarray())

x_vl = np.float32(x_vl.toarray())

#

# Полученные векторы документов передаются классификаторам – SGD и НС

# Классификация выполняется трижды

# Результаты (точность классификации) усредняются

for k in range(3):

print('Номер попытки:', k + 1)

classify(x_trn, y_trn, x_vl, y_vl)

Результаты:

| Номер попытки | SGD | НС | ||

|---|---|---|---|---|

| val_acc | acc | val_acc | acc | |

| CountVectorizer (CV) | ||||

| 1 | 96.88 | 100.0 | 99.11 | 100.0 |

| 2 | 97.99 | 100.0 | 98.66 | 100.0 |

| 3 | 96.43 | 100.0 | 98.88 | 100.0 |

| TfidfVectorizer (Tf-idf) | ||||

| 1 | 98.88 | 100.0 | 98.66 | 100.0 |

| 2 | 99.11 | 100.0 | 98.88 | 100.0 |

| 3 | 98.66 | 100.0 | 98.88 | 100.0 |

Латентное размещение Дирихле (LDA) [7] – это один из методов тематического моделирования, в котором определяются распределения слово – тема и документ – тема. В качестве априорного берется распределение Дирихле. Число тем указывается в качестве параметра метода.

При описании алгоритма LDA [7] используются следующие понятия:

- слово – элемент словаря с индексами {1, ..., V}.

Для представления слова используется модель one-hot: слово с индексом v представляется вектором w размера V, в котором w[v] = 1, а прочие компоненты – 0;

- документ – последовательность N слов d = (w1, ..., wN);

- корпус – коллекция M документов D = (d1, ..., dM).

Решается задача поиска вероятностной модели корпуса – поиска распределений слово – тема и документ – тема.

Алгоритм LDA основывается на предположении, что каждый документ корпуса относится к одной из скрытых (неизвестных) тем, и каждая тема характеризуется некоторым распределением слов. Последовательность реализации LDA:

# Распределение Пуассона, можно взять иное

1. Выбрать N ∼ Poisson(ξ).

2. Выбрать θ ∼ Dir(α). # Распределение Дирихле

3. Для каждого документа d из D:

# Мультиноминальное распределение

Выбрать тему zn ∼ Multinomial(θ).

Выбрать с вероятностью p(wn | zn, β) слово wn, где p(wn | zn, β) – мультиномиальная условная вероятность принадлежности слова wn теме zn.

В [7] сделано несколько упрощающих допущений. Во-первых, размерность k распределения Дирихле и, следовательно, число тем предполагаются известными и фиксированными. Во-вторых, вероятности слов параметризуются k×V матрицей β, где βij = p(wj = 1 | zi = 1), которая рассматривается как фиксированная величина, подлежащая определению.

Далее в [7] приводятся формулы для распределений слово – тема, документ – тема и алгоритм получения результата – вероятностей принадлежности слов и документов k темам.

Пример получения LDA методами библиотеки scikit-learn; число тем 3 (n_components = 3).

from sklearn.decomposition import LatentDirichletAllocation

from sklearn.feature_extraction.text import CountVectorizer

# Корпус из 4-х документов

corp = ['Заяц в лес бежал по лугу,',

'Я из лесу шел домой, –',

'Бедный заяц с перепугу (заяц)',

'Так и сел передо мной!']

vec = CountVectorizer(token_pattern = '\w+', binary = False)

x = vec.fit_transform(corp) # x – class 'scipy.sparse.csr.csr_matrix'

lda = LatentDirichletAllocation(n_components = 3, random_state = 0)

lda.fit(x) # Получаем LDA

print('Вероятности "слово - тема"')

print(lda.components_) # Массив формы (n_components, размер_словаря)

# [[0.33380389 1.33167202 ... 1.33144111]

# [0.33462881 0.33449496 ... 0.33473411]

# [1.3315673 0.33383302 ... 0.33382478]]

x = lda.transform(x) # Вероятности "документ – тема"

print('Вероятности "документ - тема"')

for d in x:

print(d)

[0.90036875 0.04861569 0.05101557]

[0.88730686 0.05672797 0.05596517]

[0.05723641 0.05640735 0.88635625]

[0.05591795 0.05665323 0.88742883]

Чтобы получить LDA, методу fit из LatentDirichletAllocation нужно передать векторизованный корпус в виде мешка слов, подготовку которого выполняет метод fit_transform из CountVectorizer.

Результатом подготовки данных является бинарный файл, хранящий векторы с вероятностями документ-тема.

Число тем задается равным числу классов в корпусе. Каждый вектор отвечает одному документу корпуса, и является, таким образом, векторным представлением документа.

Формирование векторных представлений документов корпуса на основе LDA обеспечивает следующий код:

import numpy as np

from sklearn.decomposition import LatentDirichletAllocation

from sklearn.feature_extraction.text import CountVectorizer

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

fn_xt, fn_xv, fn_wv = 'b_x_t.txt', 'b_x_v.txt', 'b_LDA.bin'

x_trn = read_txt_f(fn_xt)

x_vl = read_txt_f(fn_xv)

x_trn.extend(x_vl) # Объединяем x_trn и x_vl и получаем полный корпус

num_classes = 5 # Число классов (тем)

print('Создание LDA-векторов. Число тем:', num_classes)

vec = CountVectorizer(token_pattern = '\w+', binary = False)

x_trn = vec.fit_transform(x_trn)

lda = LatentDirichletAllocation(n_components = num_classes, random_state = 0)

x_trn = lda.fit_transform(x_trn) # sklearn.decomposition._lda.LatentDirichletAllocation

fn = open(fn_wv, 'wb')

fn.write(np.float32(x_trn))

fn.close()

На этапе классификации после модели загрузки в массив меняется его форма и затем устанавливается соответствие номер темы – номер класса, такое, при котором наблюдается максимальная точность классификации. После этого в списках с метками последние заменяются на соответствующие номера тем.

Поскольку LDA-векторы содержат вероятности документ – тема (класс), то номера предсказанного класса – это индекс наибольшего элемента LDA-вектора.

Документ классифицирован верно, если номер предсказанного класса совпадает с номером метки документа.

import numpy as np

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

# Вычисление точности по вектору частоты

# (вектору вероятности принадлежности документа классу)

def one_eval(knd, x, y):

n_true = 0

for vec, cls in zip(x, y):

if cls == vec.argmax(): n_true += 1

print('Точность на ' + knd + ' множестве', round(n_true / len(y) * 100, 2))

fn_yt, fn_yv, fn_wv = 'b_y_t.txt', 'b_y_v.txt', 'b_LDA.bin'

y_trn = read_txt_f(fn_yt, to_int = True)

y_vl = read_txt_f(fn_yv, to_int = True)

num_classes = 5 # Число классов (тем)

with open(fn_wv, 'rb') as fn:

x_trn = np.fromfile(fn , dtype = 'float32')

len_trn = len(y_trn)

x_trn.shape = (len_trn + len(y_vl), num_classes) # Все векторы

# Нужно LDA-темам найти соответствующие номера классов документов

# Алгоритм:

# Взять документы класса i

# Найти точность классификаций для всех тем LDA и поставить классу i в соответствие

# тему с наибольшей точностью классификации

y = y_trn.copy()

y.extend(y_vl)

lst_n = []

for c in range(num_classes):

lst = [0]*num_classes

for cls, vec in zip(y, x_trn):

if c == cls:

c2 = vec.argmax()

lst[c2] += 1

lst_n.append([c, lst])

cls_numb = [0]*num_classes # Список соответствий класс - тема

for c in range(num_classes):

lst = lst_n[c][1]

m = np.array(lst).argmax()

cls_numb[c] = m

##for c in range(num_classes): print(lst_n[c])

##print(cls_numb)

# Уточняем cls_numb вручную:

cls_numb = [1, 2, 4, 3, 0] # bbc

def make_new_y(y_trn_vl, cls_numb):

y = [cls_numb[cls] for cls in y_trn_vl]

return y

y_trn = make_new_y(y_trn, cls_numb)

x_vl = x_trn[len_trn:] # Делим векторы на проверочные и обучающие

x_trn = x_trn[:len_trn]

y_vl = make_new_y(y_vl, cls_numb)

one_eval('проверочном', x_vl, y_vl) # Точность классификации

one_eval('обучающем', x_trn, y_trn)

Результат:

Точность на проверочном множестве 68.53%

Точность на обучающем множестве 71.86%

Если же задать, например, 768 тем и LDA-векторы документов подать на вход классификаторов то получим в случае SGD:

Точность на проверочном множестве 81.70% Точность на обучающем множестве 92.35%

и в случае НС:

Точность на проверочном множестве 86.38% Точность на обучающем множестве 91.67%

Опираясь на латентно-семантический анализ (LSA) [8] (он же LSI – латентно-семантическое индексирование), можно выполнять тематическое моделирование, выделяя в документе темы и слова в этих темах.

Вероятностная разновидность метода (pLSA), подобно LDA, находит распределения документ – тема и слово – тема, которые, в частности, можно употребить для решения задачи классификации.

Пример получения LSA-векторов:

def treat_corp(corp):

from gensim import corpora

# Теперь каждый документ - это список слов

docs = [d.split() for d in corp]

# Словарь корпуса

dct = corpora.Dictionary(docs) # len(dct) = len(lst_dict)

# Получаем матрицу документ - слово (мешок слов)

doc_term_matrix = [dct.doc2bow(doc) for doc in docs]

return dct, doc_term_matrix

#

num_classes = 5 # Число классов (тем)

x_trn, y_trn, x_vl, y_vl, _ = read_corp()

len_trn = len(x_trn)

x_trn.extend(x_vl)

dct, doc_term_matrix = treat_corp(x_trn)

from gensim.models import LsiModel

# Обучение модели

lsa_model = LsiModel(doc_term_matrix, num_topics = num_classes, id2word = dct)

for t_words in lsa_model.print_topics(num_topics = num_classes, num_words = 5):

print(t_words)

# 5 слов в каждой теме

# (0, '0.708*"the" + 0.340*"to" + 0.275*"of" + 0.254*"and" + 0.223*"in"')

# (1, '0.488*"the" + -0.375*"to" + -0.291*"is" + -0.247*"that" + -0.226*"it"')

# (2, '0.543*"he" + 0.301*"to" + 0.287*"mr" + 0.263*"said" + 0.244*"his"')

# (3, '0.392*"to" + 0.250*"said" + -0.246*"it" + -0.234*"and" + 0.231*"of"')

# (4, '-0.662*"in" + 0.356*"the" + -0.308*"and" + 0.172*"mr" + 0.112*"that"')

# class 'gensim.interfaces.TransformedCorpus'

lsa_vecs = lsa_model[doc_term_matrix] # Получаем векторы [(тема, координата), ...]

# Можно получить один вектор:

lsa_vec0 = lsa_model[doc_term_matrix[0]]

print(x_trn[0])

print(doc_term_matrix[0])

print(lsa_vecs[0])

print(lsa_vec0) # То же, что и lsa_vecs[0]

# Документ: ad sales boost time warner... on the value of that stake

# Doc2bow-модель документа: [(0, 2), (1, 1), (2, 1), ..., (208, 4)]

# Lsi-вектор: [(0, 34.07), (1, -3.36), (2, 0.82), (3, -6.05), (4, -5.45)]

# dct[208] - это year; year встречается в первом документе 4 раза: (208, 4)

x_trn = [[v[1] for v in vecs] for vecs in lsa_vecs]

# Векторы проверочного и обучающего множеств

x_vl = x_trn[len_trn:]

x_trn = x_trn[:len_trn]

LSA-модель применяется, например, для кластеризации документов, поиска данных, выработки рекомендаций в результате анализа профилей пользователей.

В ЧКМ, подобно LDA, вычисляются вероятности слово – класс. В отличие от LDA, вычисления выполняются на обучающем множестве с использованием сведений о классе документа: для каждого слова из словаря корпуса формируется вектор p длины C (C – число классов), в котором pc = nc / nd, где nc – число присутствий слова в документах класса c, а nd – число присутствий слова в документах всех классов.

На основе векторов слов формируются векторы документов обоих множеств: обучающего и проверочного. Номер класса документа так же, как и при работе с LDA, определяется по индексу максимального значения в векторе документа.

При подготовке данных формируется словарь, в котором для каждого слова указан вектор p, элемент p[c] которого – суть число присутствий слова в классе c набора данных.

Далее элементы вектора делятся на число присутствий слова во всех классах и интерпретируются как вероятности попадания слова в классы.

Подготовку данных и вычисление точности классификации реализует следующий код:

import numpy as np

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

def read_corp():

path = ''

fn_xt, fn_yt, fn_d = 'b_x_t.txt', 'b_y_t.txt', 'b_dict.txt'

fn_xv, fn_yv = 'b_x_v.txt', 'b_y_v.txt'

x_trn = read_txt_f(path + fn_xt)

y_trn = read_txt_f(path + fn_yt, to_int = True)

x_vl = read_txt_f(path + fn_xv)

y_vl = read_txt_f(path + fn_yv, to_int = True)

# Список из слов словаря корпуса

lst_dict = read_txt_f(fn_d)

return x_trn, y_trn, x_vl, y_vl, lst_dict

def make_dict_f_words(x_trn, y_trn, num_classes):

dict_all_words = {}

dict_cls_words = {}

for cls in range(num_classes):

dict_cls_words[cls] = {}

for d, cls in zip(x_trn, y_trn):

d = d.split()

d_cls = dict_cls_words[cls]

for w in d:

if dict_all_words.get(w) is None:

dict_all_words[w] = 1

else:

dict_all_words[w] += 1

if d_cls.get(w) is None:

d_cls[w] = 1

else:

d_cls[w] += 1

dict_f_words = dict_all_words.copy()

for w, k in dict_f_words.items():

dict_f_words[w] = np.zeros(num_classes)

for cls in range(num_classes):

d_cls = dict_cls_words[cls]

for w, f in d_cls.items():

f = f / dict_all_words[w]

dict_f_words[w][cls] = f

return dict_f_words

def make_trn_vl_15(lst, dict_f_words):

x_trn_vl = []

for d in lst:

d = d.split()

nw = nv = 0

v = np.zeros(num_classes)

for w in d:

f = dict_f_words.get(w)

if f is not None:

v += f

nw += 1

x_trn_vl.append(v / nw)

return x_trn_vl

# Вычисление точности по вектору частоты

# (вектору вероятности принадлежности документа классу)

def one_eval(knd, x, y):

n_true = 0

for vec, cls in zip(x, y):

if cls == vec.argmax(): n_true += 1

print('Точность на ' + knd + ' множестве', round(n_true / len(y) * 100, 2))

num_classes = 5 # Число классов

x_trn, y_trn, x_vl, y_vl, _ = read_corp()

dict_f_words = make_dict_f_words(x_trn, y_trn, num_classes)

x_trn = make_trn_vl_15(x_trn, dict_f_words)

x_vl = make_trn_vl_15(x_vl, dict_f_words)

one_eval('проверочном', x_vl, y_vl)

one_eval('обучающем', x_trn, y_trn)

Результат:

Точность на проверочном множестве 95.09%

Точность на обучающем множестве 98.42%

В СВ для каждого слова из словаря генерируется на основе равномерного распределения вектор размера size (size = 150).

Затем формируется модель документа, в которой каждое слово заменяется соответствующим сгенерированным для него вектором, а вектор документа создается в результате усреднения векторов слов документа.

Подготовку данных и передачу их классификаторам выполняет следующий код:

import numpy as np

# Загрузка текстового файла в список

def read_txt_f(fn, encoding = 'utf-8', no_n = True, say = True, to_int = False):

with open(fn, 'r', encoding = encoding) as f:

lst = f.readlines() # class 'list'

if no_n:

lst = [x.replace('\n', '') for x in lst]

if to_int:

lst = [int(x) for x in lst] # При чтении меток

if say: print('Прочитан файл', fn, 'с числом строк', len(lst))

return lst

def read_corp():

path = ''

fn_xt, fn_yt, fn_d = 'b_x_t.txt', 'b_y_t.txt', 'b_dict.txt'

fn_xv, fn_yv = 'b_x_v.txt', 'b_y_v.txt'

x_trn = read_txt_f(path + fn_xt)

y_trn = read_txt_f(path + fn_yt, to_int = True)

x_vl = read_txt_f(path + fn_xv)

y_vl = read_txt_f(path + fn_yv, to_int = True)

# Список из слов словаря корпуса

lst_dict = read_txt_f(fn_d)

return x_trn, y_trn, x_vl, y_vl, lst_dict

# Формирование из списка слов словаря с элементами {слово:код слова}

def make_dict_from_list(lst, k0):

dict_x = {}

k = k0

for x in lst:

k += 1

if dict_x.get(x) is None:

dict_x.update({x : k})

return dict_x

def rand_vecs(x_trn, x_vl, lst_dict, size = 150):

print('Случайно генерируемые векторы слов')

print('Размер вектора:', size)

dict_a = make_dict_from_list(lst_dict, 0) # Формируем словарь

for w in dict_a.keys():

dict_a[w] = list(np.random.uniform(-1, 1, [size]))

def make_trn_vl_5(x_trn_vl):

x_trn_vl_codes = [] # Список векторных представлений документов

for doc in x_trn_vl:

doc = doc.split()

cw_sum = np.zeros(size)

nw = 0 # nw - число векторов, добавленных к cw_sum

for w in doc:

if dict_a.get(w) is not None:

cw = dict_a[w]

cw_sum += cw

nw += 1

x_trn_vl_codes.append(cw_sum / nw)

return x_trn_vl_codes

x_trn = make_trn_vl_5(x_trn)

x_vl = make_trn_vl_5(x_vl)

return x_trn, x_vl

def classify(x_trn, y_trn, x_vl, y_vl):

from sklearn.linear_model import SGDClassifier

doc_clf = SGDClassifier(loss = 'hinge', max_iter = 1000, tol = 1e-3)

doc_clf.fit(x_trn, y_trn) # Обучение классификатора

print('Оценка точности классификации')

score = doc_clf.score(x_vl, y_vl) # class 'numpy.float64'

print('Точность на проверочном множестве:', round(score, 4))

score = doc_clf.score(x_trn, y_trn) # class 'numpy.float64'

print('Точность на обучающем множестве:', round(score, 4))

#

epochs = 90 # Число эпох обучения НС

num_classes = 5 # Число классов

def nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc):

from keras.models import Model

from keras.layers import Input, Dropout, Dense

import keras.utils as ut

print('Преобразуем списки в массивы')

x_trn = np.array(x_trn, dtype = 'float32')

x_vl = np.array(x_vl, dtype = 'float32')

# Переводим метки в one-hot представление

y_trn = ut.to_categorical(y_trn, num_classes)

y_vl = ut.to_categorical(y_vl, num_classes)

inp_shape = (n_attrs_in_doc, )

print('Формируем модель НС')

inp = Input(shape = inp_shape, dtype = 'float32')

x = Dropout(0.3)(inp)

x = Dense(32, activation = 'relu')(x)

output = Dense(num_classes, activation = 'softmax')(x)

model = Model(inp, output)

model.summary()

model.compile(optimizer = 'adam', loss = 'categorical_crossentropy', metrics = ['accuracy'])

# Обучаем НС

model.fit(x_trn, y_trn, batch_size = 64, epochs = epochs, verbose = 2,

validation_data = (x_vl, y_vl))

# Оценка модели НС на оценочных данных

score = model.evaluate(x_vl, y_vl, verbose = 0)

# Вывод потерь и точности

print('Потери при тестировании: ', score[0])

print('Точность при тестировании:', score[1])

# После преобразования: x_trn, x_vl: class 'numpy.ndarray'

n_attrs_in_doc = len(x_vl[0])

print('Число признаков в документе:', n_attrs_in_doc)

nn_model_fit(x_trn, y_trn, x_vl, y_vl, num_classes, epochs, n_attrs_in_doc)

x_trn, y_trn, x_vl, y_vl, lst_dict = read_corp()

x_trn, x_vl = rand_vecs(x_trn, x_vl, lst_dict, size = 150)

#

# Полученные векторы документов передаются классификаторам – SGD и НС

# Классификация выполняется трижды

# Результаты (точность классификации) усредняются

for k in range(3):

print('Номер попытки:', k + 1)

classify(x_trn, y_trn, x_vl, y_vl)

Результаты:

| Номер попытки | SGD | НС | ||

|---|---|---|---|---|

| val_acc | acc | val_acc | acc | |

| size = 768 | ||||

| 1 | 94.54 | 99.94 | 95.98 | 97.69 |

| 2 | 90.40 | 99.83 | 96.21 | 97.07 |

| 3 | 93.08 | 99.77 | 95.98 | 96.00 |

| size = 1024 | ||||

| 1 | 96.65 | 99.94 | 98.21 | 98.37 |

| 2 | 97.32 | 99.89 | 98.44 | 98.65 |

| 3 | 96.88 | 99.94 | 98.44 | 98.31 |

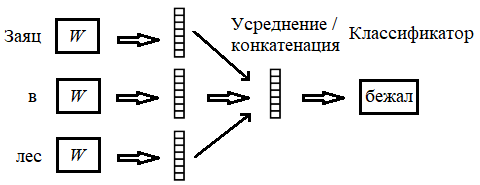

Word2vec (word to vector), наряду с такими моделями, как GloVe (global vectors for word representation) и fasttext, учитывает связи между словами в предложениях корпуса. В word2vec реализованы две модели – это CBOW (непрерывный мешок слов) и Skip-Gram (n-грамма с пропуском слова) [9]. В обеих моделях слова представляются в виде вещественных векторов заданного размера. Компоненты вектора размера n интерпретируются как координаты слова в n-мерном пространстве представления слов.

Векторы получаются в результате обучения НС либо прогнозировать слово по контексту (CBOW), либо контекст по слову (Skip-Gram).

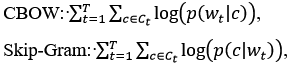

Формально word2vec максимизируется правдоподобие корпуса, заданного последовательностью слов w1, ..., wT:

где p(wt|c) и p(c|wt) – соответственно условные вероятности предсказания слова wt по контексту c и контекста по слову.

Ct – множество контекстов слова wt.

Каждый контекст – это слова, окружающие wt. Размер контекста является одним из параметров модели.

НС обучается на некотором корпусе. При его изменении word2vec-модель следует создать заново.

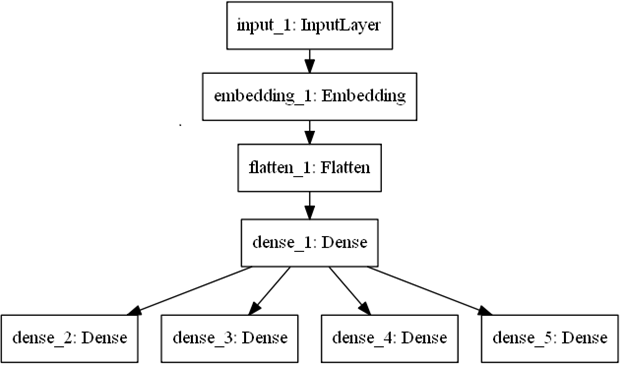

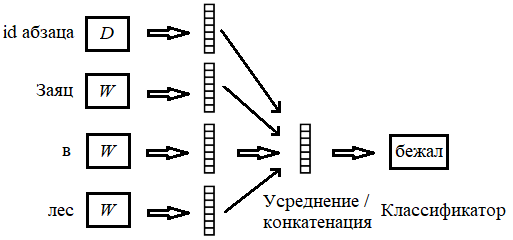

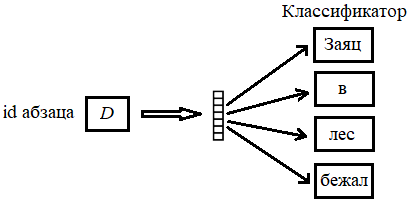

Задача прогнозирования сводится к задаче классификации. В случае CBOW на вход НС подается контекст слова word – последовательность заданного числа правых и левых соседей слова word. Каждое слово контекста представлено своим числовым кодом.

На выходе имеем прогноз НС – вектор размера num_words + 1, где num_words – число слов в словаре корпуса.

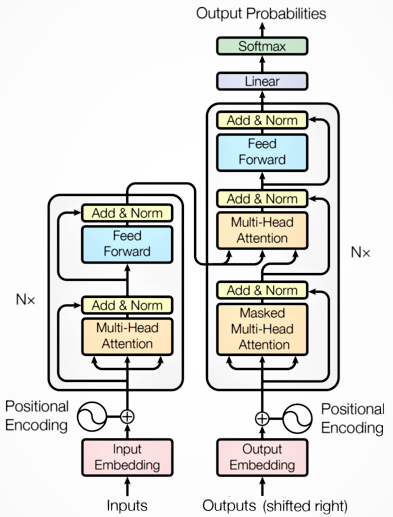

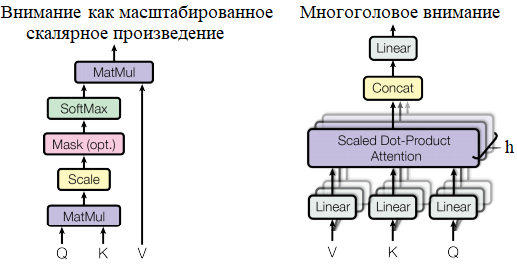

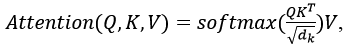

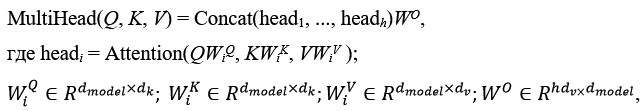

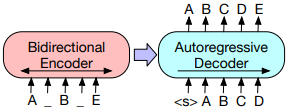

Модель НС, созданная средствами Keras, может иметь указанные на рис. 1 слои; их описание дано в табл. 1.

Рис. 1. Слои НС при реализации CBOW

Таблица 1. Описание слоев НС при реализации CBOW

| Слой (тип) | Форма выхода | Число параметров |

|---|---|---|

| input_1 (InputLayer) | (None, 4) | 0 |

| embedding_1 (Embedding) | (None, 4, 50) | 905100 |

| flatten_1 (Flatten) | (None, 200) | 0 |

| dense_1 (Dense) | (None, 50) | 10050 |

| dense_2 (Dense) | (None, 18102) | 923202 |

Искомые векторы являются весами слоя dense_2 и получаются после обучения НС следующим образом:

from keras import backend as K

def get_wei(model, nL):

L = model.layers[nL]

wei_d = L.weights

n_w = len(wei_d)

bias = None

if n_w == 0:

wei = None

else:

wei = K.eval(wei_d[0])

if n_w > 1:

bias = wei_d[1]

bias = K.eval(bias)

return wei, bias

wei, _ = get_wei(model, 4) # model – модель НС

Код формирования модели НС:

from keras.models import Model

from keras.layers import Embedding

from keras.layers import Input, Dense, Flatten

from keras import initializers

import keras.losses as ls

def create_model(sq, num_words, size):

w_init = initializers.RandomNormal()

inp = Input(shape = (sq, ), dtype = 'int32')

x = Embedding(num_words, output_dim = size, input_length = sq,

embeddings_initializer = w_init, trainable = True)(inp)

x = Flatten()(x)

x = Dense(size, activation = 'linear', use_bias = True)(x)

output = Dense(num_words, activation = ' softmax', use_bias = True)(x)]

model = Model(inp, output)

model.summary()

return model

model = create_model(sq, num_words, size)

model.compile(optimizer = 'adam', loss = ls.binary_crossentropy, metrics = ['accuracy'])

В приведенном коде:

sq – размер контекста (sq = 4);

size – размерность пространства представления (длина вектора, представляющего слово, size = 50);

num_words – размер словаря корпуса текста + одно слово (num_words = 18102).

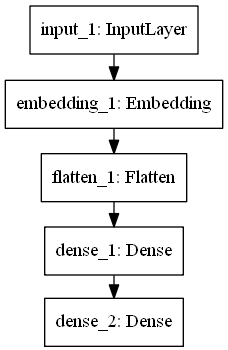

Структура НС при получении модели Skip-Gram при sq = 4 показана на рис. 2.

Рис. 2. Структура НС при реализации Skip-Gram

Код создания модели НС отличается только определением ее выходных слоев, задаваемых списком outputs:

outputs = []

for k in range(sq):

outputs.append(Dense(num_words, activation = 'linear')(x))

model = Model(inp, outputs = outputs)

Заметим, что при обучении НС применяются как положительные, так и отрицательные примеры [9].

Так, в случае Skip-Gram положительные примеры – это найденные в корпусе контексты слова, поданного на вход НС, а отрицательные – это контексты, сформированные из случайно выбранных слов словаря корпуса.

Использование приведенных на рис. 1 и 2 НС связано с большими временными затратами и, кроме того, требует предварительной обработки корпуса текста, в частности, для устранения перекосов обучения, возникающих из-за наличия часто употребляемых слов [9].

Быстрое и качественное построение word2vec-модели можно выполнить средствами библиотеки Gensim [gensim], подавая на вход построителя следующие параметры:

data – список абзацев корпуса следующего вида:

[['мой', 'дядя', 'самых', 'честных', 'правил'], ..., ];

sg = 0 – используем модель CBOW (по умолчанию); sg = 1 – используем модель Skip-Gram (по умолчанию sg = 0);

window – максимальное расстояние между текущим словом и словами около него;

min_count – слово должно встречаться в корпусе текста минимум min_count раз, чтобы модель его учитывала;

n_iter - число итераций.

import multiprocessing

from gensim.models import Word2Vec

from gensim.models.word2vec import LineSentence

data = LineSentence(<имя текстового файла с корпусом>)

workers = multiprocessing.cpu_count()

model = Word2Vec(data, size = size, window = window, min_count = min_cnt,

sg = sg, workers = workers, iter = n_iter) # iter = 5 (по умолчанию)

В обученной модели близкие по значению слова позиционируются рядом в пространстве представления слов.

Методы word2vec позволяют выполнять различные операции со словами, а точнее с представляющими их векторами, например, вычислять расстояния между ними или получать слова, наиболее близкие к заданному.

Модель имеет недостатки. В частности, она не учитывает порядок слов и не различает омонимы. Так, глагол и существительное пила (ср. девочка пила воду и пила стояла за печкой) будут представлены в модели одним вектором.

Создадим word2vec-модель по корпусу текста, загрузив его из файла corp.txt, и запишем ее в файл w2v.model.

def make_word2vec(sg, size, window, min_cnt, n_iter, fn_c, fn_wv, wv_train = False):

import multiprocessing

from gensim.models import Word2Vec

from gensim.models.word2vec import LineSentence

print('Создание word2vec-модели по файлу', fn_с)

print('Читаем файл', fn_c)

# Загружаем записи файла и преобразуем их в списки:

# получим

# ['жалобно', 'скрипели', 'оконные', 'ставни']

# вместо

# 'жалобно скрипели оконные ставни'

data = LineSentence(fn_c) # class 'gensim.models.word2vec.LineSentence'

#for x in data: print(x)

workers = multiprocessing.cpu_count()

print('Создаем word2vec-модель: \n sg =', sg, '\n size =', size,

'\n min_cnt =', min_cnt, '\n window =', window, '\n n_iter =', n_iter,

'\n multiprocessing.cpu_count =', workers)

start_time = time.time() # Время начала создания word2vec-модели

if wv_train:

print('Модель создается за три этапа: wv_train =', wv_train)

model = Word2Vec(size = size, window = window, min_count = min_cnt,

sg = sg, workers = workers, iter = n_iter)

model.build_vocab(data)

cnt = model.corpus_count ## Число строк в корпусе текста

model.train(data, total_examples = cnt, epochs = n_iter, report_delay = 1)

else:

print('Модель создается за один этап: wv_train =', wv_train)

model = Word2Vec(data, size = size, window = window, min_count = min_cnt,

sg = sg, workers = workers, iter = n_iter) # iter = 5 (по умолчанию)

print('Время создания word2vec-модели:', round(time.time() - start_time, 0))

print('word2vec-модель записана в файл', fn_wv)

model.save(fn_wv)

return model

#

sg, size, window, min_cnt, n_iter = 0, 50, 3, 2, 30

make_word2vec(sg, size, window, min_cnt, n_iter, 'corp.txt', 'w2v.model')

Примеры использования методов и свойств word2vec приведены в следующем коде:

from gensim.models import Word2Vec

# Некотрые методы и свойства word2vec

# Загрузка ранее созданной word2vec-модели

model = Word2Vec.load('w2v.model')

# Число строк (предложений) в корпусе

print(model.corpus_count) # 12'197

# Всего слов в корпусе

print(model.corpus_total_words) # 110'339

# wv – индексированные векторы слов

wv = model.wv

# Словарь модели

vocab = wv.vocab

# Число слов в словаре модели

n_words_wv = len(vocab)

print(n_words_wv) # 13'966

#

# Слова для последующего использования

word = 'глаза'

word2 = 'сердце'

word3 = 'хлеб'

#

# Координаты слова word

print(wv[word])

# или

print(wv.get_vector(word))

#

# Расстояние между словами

print(wv.distance(word, word2)) # 0.44

print(wv.distance(word, word3)) # 0.59

print(wv.distance(word2, word3)) # 0.04

#

# Массив расстояний между словом и словами из последующего кортежа

print(wv.distances(word, (word, word2, word3))) # [0. 0.44 0.59]

# Массив расстояний между словом и всеми прочими словами

print(wv.distances(word)) # [1.17 0.8 0.5 ... 0.53 0.42 0.47]

#

# Список кортежей, содержащих слова, наиболее близко расположенные

# в созданной модели к заданному слову

sims = model.similar_by_word(word)

print(sims)

# word = 'глаза'

# [('лицо', 0.89), ('подсчитывая', 0.87), ('закрыл', 0.86),

# ('губы', 0.85), ('словно', 0.85), ('голову', 0.83),

# ('ноги', 0.82), ('увидел', 0.81), ('широко', 0.81), ('сквозь', 0.81)]

#

# Список кортежей, содержащих слова, наиболее близко расположенные

# к заданному вектору

vec = wv.get_vector(word)

sims = model.similar_by_vector(vec)

# word = 'глаза'